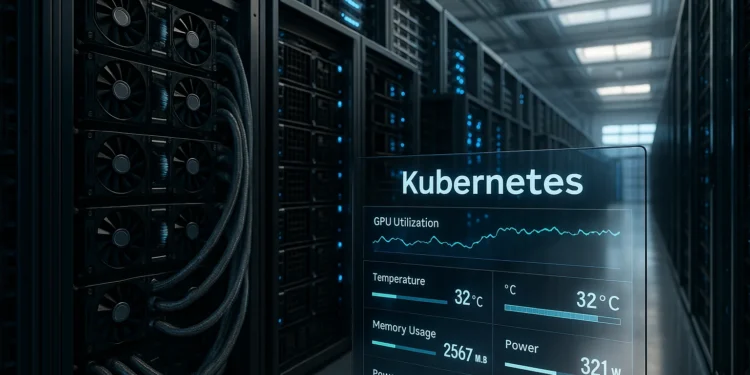

Από serverless web apps σε multi-GPU πολύπλοκες ροές AI

Η τεχνολογία Kubernetes δεν είναι πλέον απλώς μία πλατφόρμα για web και microservices: έχει εξελιχθεί στους κεντρικούς μηχανισμούς ορχήστρωσης που απαιτούνται για τις σημερινές απαιτητικές εργασίες τεχνητής νοημοσύνης (AI) — και πλέον το ζητούμενο είναι η αλλαγή στον τρόπο που οργανώνεται η υποδομή.

Η αντίληψη πως η «φούσκα της AI» (AI bubble) ίσως σκάσει, δεν αλλάζει το γεγονός: η AI δεν είναι απλώς τάση, αλλά κρίσιμος παράγοντας για τον τεχνολογικό κλάδο. Η ζήτηση για υποδομές — κυρίως GPU ενισχυμένες — έχει εκτοξευθεί, καθώς η εκπαίδευση μεγάλων γλωσσικών μοντέλων (LLMs) ή η εκτέλεση inference για AI δυνατότητες απαιτεί στόλους από GPUs, σε κλίμακα που παλαιότερα βλέπαμε μόνο σε υπερυπολογιστικά κέντρα (supercomputing).

Συχνά οι ομάδες αναγκάζονται να διασπάσουν ένα μοντέλο σε πολλές GPUs, ή να θέσουν pipelines πολλών σταδίων και να βελτιστοποιούν συνεχώς για throughput και latency, προκειμένου να κρατηθούν οι εργασίες AI σε λειτουργική κατάσταση.

Παράλληλα, εμφανίζονται εργαλεία όπως το NVIDIA DCGM Exporter για την παρακολούθηση κατανεμημένων GPUs, καθώς και τεχνικές όπως topology-aware scheduling.

Τα κρίσιμα σημεία πίεσης

Πρώτον, το κόστος. Οι GPU-instances στο cloud είναι ακριβές και χρεώνονται είτε είναι ενεργές είτε αδρανείς. Άρα η μέγιστη εκμετάλλευση των clusters είναι απαραίτητη.

Δεύτερον, η κλίμακα. Τα μοντέλα που δεν χωράνε σε μία GPU απαιτούν διαμοιρασμό σε πολλούς επιταχυντές και nodes.

Τρίτον, η διαχείριση πόρων. Πώς να εξασφαλιστεί ότι οι πόροι (GPU, μνήμη, I/O) χρησιμοποιούνται αποδοτικά, με ελαχιστοποίηση της σπατάλης;

Γιατί το Kubernetes έχει θέση εδώ

Το Kubernetes, αν και αρχικά σχεδιασμένο για stateless web εφαρμογές, έχει προσαρμοστεί ικανοποιητικά στα AI-workloads — και υπάρχουν αρκετοί λόγοι:

- Μεσολαβεί ως κοινό επίπεδο για container orchestration, αυτόματη κλιμάκωση, διαχείριση κόμβων και απομόνωση.

- Με τις σύγχρονες επεκτάσεις και plugins, υποστηρίζει GPU-clusters, distributed training frameworks (π.χ. TensorFlow, PyTorch) και ML pipelines.

- Η πρόσφατη εισαγωγή του χαρακτηριστικού Dynamic Resource Allocation (DRA) στο Kubernetes (ως GA από έκδοση v1.34) επιτρέπει πιο δυναμική, device-aware και topology-aware διαχείριση επιταχυντών.

Τι είναι το DRA και γιατί έχει σημασία

Το DRA (Dynamic Resource Allocation) εισάγει στο Kubernetes ένα μοντέλο «συσκευής ως πόρου» αντί της παραδοσιακής διαχείρισης GPU ως «μαύρου κουτιού». Ορισμένα σημεία:

- Οι διαχειριστές μπορούν να ορίσουν DeviceClasses που καθορίζουν τύπους συσκευών (π.χ. gpu.nvidia.com).

- Το σύστημα υποστηρίζει ResourceSlices και ResourceClaims, επιτρέποντας Pods να ζητούν ακριβώς τον τύπο ή το πλήθος των GPUs που χρειάζονται.

- Αυτό μειώνει τον «κατακερματισμό πόρων» (resource fragmentation), καθώς και τις απώλειες από μη-βέλτιστη τοποθέτηση.

Με άλλα λόγια, όταν έχεις workloads που απαιτούν υψηλή απόδοση GPU, μεγάλη μνήμη, διασύνδεση GPU-GPU (π.χ. NVLink), τότε χρειάζεται μια ορχήστρωση που «γνωρίζει» τη φυσική τοπολογία και τα χαρακτηριστικά του υλικού — το DRA / σύγχρονα plugins του Kubernetes το υποστηρίζουν πλέον αυτό.

Πρακτικές τεχνικές & προβληματισμοί

- Monitoring & ορατότητα GPU: Είναι κρίσιμο να γνωρίζεις πότε μία GPU είναι υπόχρηστη ή idle. Το εργαλείο NVIDIA DCGM Exporter βοηθά σε αυτή την κατεύθυνση.

- Scheduling με awareness τοπολογίας: Αν η εργασία απαιτεί NVLink μεταξύ GPUs σε διαφορετικούς κόμβους, το scheduler πρέπει να το γνωρίζει ώστε να τοποθετεί σωστά τα Pods. Ένα παράδειγμα είναι η χρήση του ComputeDomains abstraction από τη NVIDIA που συνδυάζεται με DRA.

- Cost optimisation: H καλή τοποθέτηση, το sharing με vGPUs, και η χρήση spot-instances μπορούν να μειώσουν σημαντικά το κόστος.

- Distributed training & inference: Η υποδομή πρέπει να υποστηρίζει όχι μόνο single-GPU jobs αλλά και multi-node, multi-GPU jobs, pipelines με στάδια (data prep, training, serving) και realtime inference.

Πώς να προχωρήσει μια ομάδα πλατφόρμας (platform engineering)

- Καταγραφή workloads: Ποια μοντέλα χρειάζονται πόσες GPUs, ποια στάδια, ποια latency/throughput SLA;

- Καθορισμός διαθεσιμότητας πόρων: Πόσες GPU-κόμβοι διαθέτουμε, τι hardware, τι interconnect;

- Ενεργοποίηση Kubernetes GPU stack: Εγκατάσταση GPU Operator, device plugins, DRA driver, monitoring stack.

- Ορισμός DeviceClasses / ResourceClaims μέσω DRA για τα διαφορετικά σχήματα workloads (π.χ. training vs inference).

- Topology-aware scheduling: Διαμόρφωση labels/taints/affinity για NVLink, PCIe, node-clique, ώστε τα pods να τοποθετούνται σωστά.

- Κόστος & χρήση: Μετρική χρήση, idle time, spot-instances, bin-packing για GPUs ώστε να αυξηθεί η απόδοση κόστους.

- Επιτήρηση & feedback loop: Logging, metrics, alerts για GPU usage, latency, throughput, fragmentation. Συνεχής βελτίωση της κατανομής.

Συμπέρασμα

Η υιοθέτηση της τεχνολογίας για υποδομές AI απαιτεί μια μετατόπιση: από παραδοσιακή διαχείριση server-clusters σε εξειδικευμένη ορχήστρωση πόρων επιταχυντών, που παίρνει υπόψη την τοπολογία, το κόστος, και τις απαιτήσεις του μοντέλου. Το Kubernetes με λειτουργίες όπως το DRA και τη χρήση σύγχρονων abstraction για GPUs καθίσταται πλέον βασικός πυλώνας αυτής της αλλαγής.